Посоветуйте, пожалуйста, стороннее ПО для дефрагментации. Хотелось бы чего-то такого бесплатного, русифицированного и еще бы с ссылочкой для скачивания 😊 Ну, или хоть что-то 😊

perfectdisk 10

perfectdisk 10Спасибо. Я пока этот: Autologistic disc defrag скачал, в следующий раз попробую Perfectdisk 10.

Пы.Сы. А у 10 версии есть какие-то преимущества? А то я смотрю, вроде и 12 есть.

Пы.Сы. А у 10 версии есть какие-то преимущества? А то я смотрю, вроде и 12 есть.

Нет бесполезных рюшечек типа дефрагментации на лету.

Спасибо.

JkDefrag

JkDefragТоже посмотрю.

Чем плох Diskeeper 2013?

Мда... Дефрагментация диска 750гб - та еще задачка...

O&O Defragg

+1 за O&O

Фуф. С горем пополам осилил. В следующий раз попробую остальные проги. Всем спасибо.

Diskeeper - наше всё.

Он очень хорошо понимает систему и наоборот

Тем более, что виндовый дефрагментатор = сильно обрезанный Diskeeper

я UltraDefrag пользовался !

ctepneЛучший вариант.

UltraDefrag

Auslogics Disk Defrag Pro http://www.auslogics.com/en/software/disk-defrag-pro/

или в самой проге есть http://www.auslogics.com/ru/software/boost-speed/download/

UltraDefragЧестно говоря, не рискнул бы пользоваться нонеймовской утилиткой для такой глобальной работы с файловой системой

Хорошая прога с открытыми исходниками, может дефрагментировать даже системные файлы (типа свопа, реестра), можно дефрагментнуть отдельные файлы и папки. И к тому же она самая быстрая.

Быстро не всегда хорошо, а чаще - плохо.

Если не ошибаюсь, для скорости в таких случаях файл дефрагментируется не кластерами, а группами кластеров, например, по 8. Т.е. за концом каждого файла образуется хвост из пустых кластеров, в среднем 4 пустых. При записи пустые кластеры заполняются новыми фрагментами файлов. Получается, при обработке диска быстрыми оптимизаторами закладывается основа повышенной фрагментации в будущем.

Самый честный дефрагментатор был у Питера Нортона. Файлы там писались началом прямо к концу предыдущего.

К тому же для надёжности он использовал систему транзакций, т.е. обрушений FAT у него не было даже при отключении питания.

Всё это и обусловливало его низкую скорость

К сожалению, для NTFS он так и не был адаптирован

CojoryТак любой дефрагментатор так и поступает. А как "прямо к концу", а если файлы были размером меньше кластера?

Файлы там писались началом прямо к концу предыдущего.

Нет, не так.

Один за другим - когда не остаётся между файлами неиспользованных кластеров. Секторы могут оставаться.

Если дефрагментатор использует блоки по 8 кластеров, между файлами остаются от 0 до 7 пустых кластеров. Блоки кластеров - это не кластеры секторов, это именно укрупнённые блоки кластеров для ускорения работы дефрагментаторов.

Это не афишируется, но используется вовсю...

MyDefrag 4.3.1 - http://www.mydefrag.com - качественней не найти.

И все же UltraDefrag классная прога !![]()

Скачал попробовать UltraDefrag.

Пока очень нравится. Все минималистично, ничего лишнего.

ИМХО defraggler

А зачем кто-то сейчас дефрагменитрует NTFS? Я по своей дремучести уже и не помню, когда последний раз этим занимался.

А зачем кто-то сейчас дефрагменитрует NTFS? Я по своей дремучести уже и не помню, когда последний раз этим занимался.

Потому что эта система подвержена фрагментации, особенно сильно если свободного пространства на диске мало. Дефрагментация при этом оказывает впечатляющий эффект на производительность.

про деградацию производительности не согласен, по сравнению с FAT32 просто незаметно.

Могу поспорить, если речь идет о реальном использовании раздела, то есть не на уровне открыл вордовый документ - поработал - закрыл, а допустим постоянной перезаписи различных файлов, например образов виртуальных машин или файлов торрент клиента, то деградация производительности чувствуется ощутимо.

Единственное что делаю - файл подкачки выношу на отдельный физический диск и фиксирую размер. Часто меняющиеся файлы тоже размещаются на отдельном физическом диске.

Осталось добавить - "и вообще использую NAS для всего остального"... 😀

Компиляция подойдет?

Неа. Нагрузка которую дает торрент клиент на дисковую подсистему, не говоря о виртуальных машинах, просто не сравнима. Попробуйте сами, разверните образ гигов на 20, поработайте на нем и посмотрите как со временем просядет производительность, и как дефрагментация вернет все в нужное русло.

Их есть уменя, ради интереса даже попробую дефрагментировать диск, на котором они лежат. 😊

А вы ими реально пользуетесь? Просто крайне странно, что имея несколько вертуальных машин вы никогда не замечали просадок производительности от фрагментации образа.

А почему собственно скчивание нескольких сотен файлов грузит файловую систему сильнее, чем компиляция нескольких тысяч?

Оно не файловую систему, а дисковую подсистему грузит. 😛 Почему? Странный вопрос, может потому что объем данных на порядки больше, те самые сотни файлов разбиты на сотни кусков, пишутся и читаются кусками, кэширование в силу объема данных и случайности операций с ними не особо помогает и.т.д. 😊

Фрагментируется таки файловая система, и фрагментируется она при записи.

Спасибо кэп, с этим вроде как никто не спорит. 😊 Просто надо понимать, что фрагментация файловой системы и нагрузка на дисковую подсистему - это разные, хотя, и связанные вещи. Если у вас сильно фрагментирована ФС, то и нагрузка на дисковую подсистему будет значительно выше, чем при низкой или нулевой фрагментации ФС при тех же задачах. Когда ФС фрагментируется падение производительности ощущается по разному в зависимости от задач, выполняющихся ФС.

Разумные системы файлообмена резервируют потребное место заранее , а в случае генерации нового файла предсказать его размер несколько затруднительно.

Даже если резервируют, в самом простом случае все равно будет вылезать фрагментация свободного пространства, потому что ротация с удалением и последующим созданием файлов разного размера все равно присутствует. С этим можно бороться поддерживая достаточный объем свободного пространства и максимально большими кусками/куском. Дефрагментация свободного пространства тоже входит в фунции дефрагментаторов, по крайней мере, нормальных.

Да и бессмысленно дефрагментровать то, что к концу дня придет примерно в такое же состояние. "Потому и не кусают". т.е. просто нужно разделять редко меняющиеся данные и меняющиеся постоянно, тогда "ваши волосы..."

По правде не так быстро это происходит, где раза в неделю две хватает для поддержания божеского вида.

Конечно будет, у меня вот прям сейчас посмотрел, за 10% она переваливает только на диске, отданном под файлопомойку, и меня это ни разу не волнует.

Если оттуда не идет интенсивного чтения и туда ничего интенсивно не пишется, то понятно почему.

Ну т.е. все согласны, что зло, с которым тут борются это фрагментация файловой системы?

А это кто-то отрицал? Или вы это касательно своего ляпа по поводу того, что больше "нагружает файловую систему" - компиляция или скачивание файлов? Могу еще раз повторить, подобные операции нагружают дисковую подсистему, а не файловую систему, но вызывают фрагментацию файловой системы.

наверное потому что и под диски виртуальных машин я тоже отвожу место фиксированного размера .

В смысле?

А где тут "ляп"? Или вы знаете способ нагрузить дисковую подсистему файловыми операциями не нагружая файловую систему

Строго говоря, знаю, многие СУБД могут использовать и используют раздел без ФС. Но это сильный офтоп в этой теме. 😊 А ляп в том, что вы сравниваете, или правильнее сказать ставите вопрос о сравнении степени нагрузки на фс двух разных задач, который в контексте обсуждения лишен всякого смысла. Просто в силу того, что они дают минимальную нагрузку именно на ФС. А вот если бы вы поставили вопрос о том, что из них больше фрагменитрует ФС, или нагружает дисковую подсистему, тогда - другое дело.

Или скачивание нескольких файлов известного (как правило большого) размера фрагментирует файловую систему больше чем компиляция на порядок большего количества файлов (как правило мелких)?

Ой, как с вами сложно, даже не знаю с чего начать. Попробую позадавать наводящие вопросы, так будет удобнее. По-вашему я написал про торрент клиент и виртуалку, потому что они сильно фрагментируют ФС, или потому что в силу большой нагрузки на ДП в этих задачах деградация производительности при сильно фрагментированной ФС чувствуется крайне остро? По-вашему торрент клиент пишет и читает сразу большими файлами или огромным количеством мелких кусков этих файлов? По-вашему торрент клиент используется только для обмена крупными файлами, с коллекциями картинок, манги, обоев вы не сталкивались? Ваш компилятор не кэширует нужные ему файлы? У вас проекты объемом больше террабайта? По-вашему торрент клиент только пишет, не читает файлы?

Ну или фрагментация таки не влияет на нагрузку?

А сами то как думаете? Одинаковое время тратит головка на перемещение между соседними секторами или расположенными в разных точках диска? Ответ должен быть очевиден. 😊

В прямом. Виртуальные диски создаю фиксированного размера.

Места не жалко?

Оракл и MSSQL. Но в этой позе их немногие используют.

Ну не только, из тех что, что я помню: Teradata, IBM DB2, MySQL, Sybase ASE, IBM Infomix, Sybase IQ. В общем многие, оно и значит многие. Что касается подобного использования то все зависит от конкретного случая где-то использования raw оправдано, где-то нет.

Нет, потому что на машине рядового юзверя как правило нет других приложений, более зависящих от производительности дисковой подсистемы.

Упоминание рядового юзверя тут как-то не к месту... Не знаю как вы, но я мало юзверей знаю с вируталками на компе, точнее не знаю не одного. Приложений именно зависящих от производительности дисковой подсистемы в принципе мало. Но суть была в том, что торрент и виртуалка - это всем известные приложения сильно нагружающие дп и на которые очень хорошо чувствуется разница между фрагментированной фс и фс с минимальной фрагментацией.

торрент-клиент не может нагрузить дисковую подсистему просто потому, что он не протолкнет через сеть поток данных, который в состоянии отдать современный диск.

Фундаментально неправильный тезис. Производительность дп зависит от типа нагрузки - случайная, последовательная и от приложения дающего эту нагрузку. Красивые циферки получаемые при последовательном чтении в идеальных условиях не имеют ничего общего с результатами, полученными на приложениях с превалирующей случайным чтением и записью в реальных условиях. Иначе следуя вашей логике можно на СУБД сервера ставить простейшие диски, все равно же СУБД не протолкнет через сеть поток данных, который в состоянии отдать современный диск. 😀 Реально, если в торрент клиенте раздается хотя бы 50 крупных раздач, и 10 параллельно качается, то и 100 мегабитного канала не потребуется, чтобы получить перегруз диска. Естественно это все лечится различными оптимизациями в лице ограничения раздачи, большим кэшем, определенными настройками самого клиента, дефрагментацией и.т.д., но нагрузка на жесткий диск очень высокая.

Виртуальная машина как и реальная, активно использует диск только при загрузке. Только причем тут все это?

И при работе, запуск/работа приложений, своп, кэширование фс и.т.д. Никто это не отменял, или у вас как-то по другому?

Нормальный клиент создает файл сразу требуемого размера, что как правило сводит фрагментацию к минимуму.

Да не сводит, я вам уже писал почему, могу процетировать "Даже если резервируют, в самом простом случае все равно будет вылезать фрагментация свободного пространства, потому что ротация с удалением и последующим созданием файлов разного размера все равно присутствует.". А фрагментация свободного пространства перетекает в фрагментацию файлов после записи туда.

Следствием чего является меньшая деградация производительности, которая для него вторична по сравнению с производительностью сети.

Не вторична. Вы вообще когда-нибудь видели как меняется количества отдаваемых диском данных если забивается очередь и время доступа возрастает до неприличных значений, или у вас hdd=sdd?

Никогда не используйте клиент, который пишет и читает "огромным количеством", он тупо теряет время на переключение контекста.

Разбивать контент на куски нужно для поддержания эффективности файло-обмена в торрент сети, без этого никуда.

С коллекциями картинок-манг-обоев в количестве 3-6 тысяч штук в день - нет, не сталкивался и не очень понимаю зачем это.

Почему в день, один раз закочал, потом раздаешь.

Ну мы же тут за производительность боремся?

Ну да, я просто дефрагментатором пользуюсь, потому что и так уже диски некуда подключать. Хотя если вы принципиально не пользуетесь дефрагментацией, то да, для вас это единственный способ поддерживать вменяемую производительность.

Кэширует файловая система, компилятору-то зачем?

Понятно, вопросов больше не имею.

то на фоне затрат на его расширение, фрагментация тоже детский лепет.

И какие же там затраты на его расширение? 😊

Реально заметно на производительность системы влияет фрагментация файла подкачки и процент заполнения диска, все остальное на уровне шума.

Вы же сами понимаете, что это не так, так почему спорите... 😊 Просто, если вы напишите "Реально у меня заметно на производительность системы влияет фрагментация файла подкачки и процент заполнения диска, все остальное на уровне шума.", тогда я и многие другие с вами согласятся, но пытаться распространять персональный ограниченный опыт на все и всех - не правильно. 😛

Кароче, склифасовский 😊. Дефрагментация есть гут или нет?

Кароче, склифасовский 😊 . Дефрагментация есть гут или нет?

Да, гут-гут. 😀

Эт почему? Стартовый топик, из которого случился вот этот диалог двух телевизоров он о чем?

Мне еще раз повторить...? Пожалуйста - "Не знаю как вы, но я мало юзверей знаю с вируталками на компе, точнее не знаю не одного." Много юзверей с виртуалками знаете? 😛

Почему бы это? Рядовой диск в состоянии отдавать гигабит, канал более ста мегабит встречается существенно реже. И будь там хоть тысяча клиентов, они будут стоять в очередь на канале, как на самом узком месте.

Не обижайтесь, но вы походу совсем не в теме. 😊 То сколько может отдать диск напрямую зависит от того каким образом с него происходит чтение. Если говорить об одно-потоковом последовательном чтении, а вы, судя по всему именно о нем и пишите, то да современные диски легко отдают гигабит, некоторые больше. Если говорить о много-потоковом случайном чтении, одно-потоковом случайном чтении и.т.п, то количество данных, отданных диском, будет обратно пропорционально времени доступа к ним. То есть, если у вас софт дербанит головки от сектора к сектору, скорость диска очень круто проседает. Это очень хорошо заметно на тех же торрент клиентах или в более крупном масштабе на СУБД.

Я о тех, с которыми общался.

Странно, а пишите вот что:"Рядовой диск в состоянии отдавать гигабит, канал более ста мегабит встречается существенно реже. И будь там хоть тысяча клиентов, они будут стоять в очередь на канале, как на самом узком месте". Вам любой сис. админ работающий с СУБД напишет, что часто узкое место не канал а сам диск, и чтобы это компенсировать, ставят специализированные дисковые массивы.

Ну писал же? Я выношу часто меняющиеся данные на отдельный раздел, своп фиксирую.

Что и на виртуалках для каждой отдельный раздел с часто меняющимися данными. Фиксированный своп не поможет если не открыть сразу все пространство образа виртуалки.... В общем мутно как-то...

Потому что билд раз в сутки.

Так и что? Это серьезная нагрузка что ли? Или вас проекты сотни гигов занимают на диске/ах? Или может во время компиляции они их сильно нагружают? 😀

Это как раз очевидно, лучше дайте свое определение "огромного количества".

50 коннектов это явно не оно.

А что вам конкретно не понятно? И откуда эти 50 коннетов взялись, не поленитесь, откройте вкладку bandwidth в торрент клиенте и посмотрите максимально количество соединений, у меня стоит 850.

А попробовать? Я пробовал, мне нравится как есть.

Так и я пробовал. 😀

Чем и был вызван мой первый пост в этой теме.

Э-нет, вы упускаете из виду один важный момент, я тут не в меньшинстве, это ветка по выбору дефрагментатора, и люди которые тут отписывались пользуются дефрагментаторами и признают объективную пользу от них. А вы решили им открыть Америку, только пока это больше чем на ИМХО это не тянет, увы. 😛

Примерно эквивалентно оптимизаторам реестра.

Ничего подобного.

Да, можно и еще пару раз, только что-то я не очень понимаю причем тут виртуальные машины и прочая байда. Вопрос вполне очевидно был про домашнюю машину. И да, знаю лично людей у которых на домашней машине таки есть виртуалки.

Мне то не сложно, но будет ли толк...? То есть, для огромного количества людей и меня в их числе не очевидно, что домашняя машина - это машина "рядового юзверя". Я не цепляюсь к словам, но если вы хотите написать домашняя машина или еще более общий вариант - десктоп, воркстейшн, то так и пишите. У меня тоже есть домашняя машина, но я себя юзверем не считаю, и знаю многих специалистов в области ИТ, имеющих дома компьютер, и аналогично у меня не повернется язык назвать их юзверями.

Дык не на что же. Просто смешно.

А должно быть грустно. 😛

Мы все еще о домашней машине? Что-то я себе слабо представляю админа сильно нагруженного сервера, задающего вопрос по поводу дефрагментации диска на оружейном форуме. И еще менее представляю себе такой сервер на одном ширпотребном интерфейсе.

Разумеется, просто, если не вырывать мою фразу из контекста сообщения и не перевирать его смысл, тогда не придется представлять какого-то админа нагруженного сервера, задающего вопрос по поводу дефрагментации диска на оружейном форуме, и сервер на одном ширпотребном интерфейсе.... 😊

Вы написали, что "торрент-клиент не может нагрузить дисковую подсистему просто потому, что он не протолкнет через сеть поток данных, который в состоянии отдать современный диск.", я вам написал, что может и объяснил почему, в качестве примера схожей ситуации но в больших мастабах вам были приведены СУБД, с которыми, с ваших слов, вы знакомы. И тогда зачем было приплетать админа и оружейный форум?

Ну вот сейчас собирается сцуко. Сожрал все ядра и диск тарахтит не умолкая. Если бы дефрагментация эту поцедуру заметно ускоряла, я бы ее каждую ночь запускал, зуб даю.

Если у вас нет фрагментации, то она вам и не поможет... Если у вас узкое горлышко не диск - тем более. 😀

Ну или подскажите уже как включить кеш компилятору . Поскольку не умею - пошел пока на ганзу.

Откуда я знаю, зависит от компилятора, среды в которой вы работаете.

50 - это собственно из поста об ужасной нагрузке P2P клиентом файловой системы. 850 через дырку в даже пусть в 50 мегабит - не бог весть что.

XP помнится в состоянии открыть порядка 9000 сокетов, потребовалось тут однажды выяснить За остальные не скажу.

Сокеты тут причем...? Еще раз повторю, узкое горлышко будет диск, правильная настройка может это компенсировать, но если клиент настроен не правильно, он на раз положит диск, даже не использовав и половины 100-итного канала.

Что бы не быть голословным, ниже скрин работы торрент клиента. Диск - не самый поганый Toshiba Harrier 2TB.

Загружается только одна раздача состоящая из крупных файлов, отдается тоже одна раздача состоящая из одного крупного файла. Как видно торрент клиент даже на 15-и мегабитах грузит диск. Я совру если скажу, что такая нагрузка идет постоянно, она появляется пиками, но по мере добавления количества активных раздач, такие пики начинают стремится к линии, и в итоге юзер получает disk overload. К чему я это написал? К тому, чтобы вы поняли, что торрент клиент может серьезно нагружать диск и ему для это не обязательно нужен гигабитный или 10- гигабитный канал. Хотя пример описывает ситуацию с записью на диск, аналогичная ситуация проявляется и при чтении, при достаточных условиях, и фрагментация данных оказывает прямое влияние на степень нагрузки, которую дает торрент клиент на диск. Можно, конечно, затянуть старую волынку, что мол заранее резервируем размер - и все отлично, но я уже описывал, почему это не так.

на NTFS при озвученных условиях эффект больше психологический.

Добавляйте ИМХО, тогда звучит более правдоподобно. 😊

Забавно, сначала:

"А зачем кто-то сейчас дефрагменитрует NTFS? Я по своей дремучести уже и не помню, когда последний раз этим занимался."

"Примерно эквивалентно оптимизаторам реестра."

а потом:

"на NTFS при озвученных условиях эффект больше психологический"

а условия видимо:

"только один раздел заполнен более чем на 50% (раздел должен быть заполнен меньше чем на 50%)"

"файл подкачки выношу на отдельный физический диск и фиксирую размер. Часто меняющиеся файлы тоже размещаются на отдельном физическом диске." (часто меняющиеся файлы и своп на отдельный диск, пускай там фрагментируются, главное чтобы статистика по основному диску не портилась, иначе придется воспользоваться дефрагментатором) 😀

А когда приводится чужое мнение, обычно дается ссылка на первоисточник.

А эта ветка не подходит в качестве первоисточника?

Да, по поводу серверов тоже очень интересно, развейте тему плиз? Обязательно передам коллегам, а то у них сервер 160 миллионов изображений сравнивает целых 5 секунд. Может пора диск дефрагментировать? Пусть тоже поржут.

Вы вообще о чем, или опять придумываете за меня, или я должен должен проникнуться священным трепетом при упоминании 160 миллионов изображений сравниваемых целых 5 секунд? 😀

Пусть тоже поржут.

Вы бы свою писанину в Майкрософт направили, уж там то поржут. 😊 А то они - идиоты, деньги Дисккиперу заплатили, их софтину в пакет поставки своей ОС включили, не знали, что M.N.V уже не помнит, когда в последний раз делал дефрагментацию. 😀 😀 😀 😀

Нихрена себе, что там за ЭВМ стоит? Ей же отдельную электростанцию нужно! 😊

Я лично высказываю свое мнение, в чем противоречие?

До тех пор пока вы признаете, что это ваше личное мнение никакого противоречия и проблем - нет. 😊

Если к примеру у некто регулярно приключается триппер, то некто может либо выбирать себе самое лучшее лекарство, либо перестать трахать что попало без резинки. Мой вариант второй, предпочитаю бороться с причиной а не со следствием. 100% гарантии не дает, но сильно снижает вероятность, и на чрезвычайный случай первый вариант никто не отменял .

Замысловато. Только следую вашей аллегории, вы предлагаете скорее не не трахать, что попало без резинки, а отрезать себе соответствующий орган. 😀

И сравнивать домашнюю машину обычного пользователя с высокопроизводительными серверами как минимум смешно.

Да кто ж их сравнивает? Я даже по другому скажу, откуда вы вообще эти высокопроизводительные сервера взяли, ну что вас подвигло завести про них разговор? 😊

Да, все пять ящиков. И прошу заметить - не я это начал .То, что есть осознание факта, что конфигурация железа должна быть сбалансирована под решаемую задачу,уже хорошо. Надеюсь, осознание разницы между ПО обычного домашнего пользователя и серверов, тоже наступит.

Вот опять, о чем вы? Чтобы было понятнее, я бы был бы вам крайне признателен, если вы пояснили мне какое все это имеет отношение к тому, что я писал, и к ветке в целом. 😊

И вообще, меня сейчас гораздо больше интересует заточка опасной бритвы

Так и занимайтесь любимым делом, чего себя мучить. Я опасные бритвы точить не умею, ножи умею.

Ну так перечитайте свои посты уже? Я вот лично тоже был в легком недоумении.

Ой да ладно, я то хорошо помню, что я писал, а что нет, и то что вы не можете мне конкретно процитировать, где я поднимал тему высокопроизводительных файл/sql серверов с витуальными машинами на них - меня совершенно не удивляет. 😀

Ножи я тоже умею, бритву вот учусь, а сюда изредка поржать захожу.

Заходите чаще... 😀 😀 😀 😀

Мне тупо лень, но я попробую.

Читаем "тупо лень, но я попробую" понимаем "мне лень фантазировать, но я попробую". 😀

Постоянная перезапись образов виртуальных машин на настольной машине домашнего пользователя - это в какой вселенной?

Не домашнего пользователя, а на домашней машине, звучит похоже, но это принципиально разные понятия, домашняя машина есть и у работников ИТ сферы, у которых частенько дома для отработки рабочих ситуаций крутятся виртуалки, а домашний пользователь - это тот, кто использует компьютер дома, в большинстве своем обычные люди.

Таким образом, если заведомо не искажать смысла, вопрос должен был бы звучать так:"Постоянная перезапись образов виртуальных машин на настольной машине/домашней машине - это в какой вселенной?"

Ответ:"В нашей, среди работников ИТ часто встречающиеся явление."

Да и не хочется вам раскрывать страшную тайну, но сервера - это не только рэковые шкафы, занимающие комнату, они бывают еще и в формате miditower/fulltower и.т.д., и могут располагаться где угодно, например домашний сервер, small business сервер... А то у вас как-то все либо черное либо белое, если компьютер то обязательно домашнего юзверя, если сервер то обязательно шкаф. Вы кроме них ничего не видели что ли?

А что тогда к месту?

А вам хочется растянуть этот разговор? 😀 Я вам на этот вопрос уже не один раз в этой ветке отвечал, а вы с упорством, достойным другого применения, продолжаете мне его задавать. Ну что я могу сделать, если до вас не доходит, что дома работают не только юзвери. Это настолько очевидно, хотя бы потому, что в противном случае вас тоже можно отнести к категории домашних юзверей...

Еще раз:

Упоминание рядового юзверя тут как-то не к месту... Не знаю как вы, но я мало юзверей знаю с вируталками на компе, точнее не знаю не одного. Приложений именно зависящих от производительности дисковой подсистемы в принципе мало. Но суть была в том, что торрент и виртуалка - это всем известные приложения сильно нагружающие дп и на которые очень хорошо чувствуется разница между фрагментированной фс и фс с минимальной фрагментацией.

Это тоже о настольной машине домашнего пользователя?

Подумайте сами, это не так сложно, если я нигде не упоминал понятия "настольная машина домашнего пользователя", может я вообще о ней не писал...

На мой взгляд, человек у которого "постоянно перезаписываются" образа виртуальных машин, есть сис. админ работающий с СУБД, и которого "не к месту" упоминать как рядового пользователя не будет задавать вопросов на тему чем дефрагментировать диск.

Во-о-от, на ваш взгляд, и если он вас по каким-то причинам кривой, то его нужно исправлять... 😊 Может тогда куски чужих фраз, вырванные из контекста, не будут обретать самостоятельный смысл, и не будут вылезать перлы вроде "А почему собственно скчивание нескольких сотен файлов грузит файловую систему сильнее, чем компиляция нескольких тысяч?", "А где тут "ляп"? Или вы знаете способ нагрузить дисковую подсистему файловыми операциями не нагружая файловую систему?", "торрент-клиент не может нагрузить дисковую подсистему просто потому, что он не протолкнет через сеть поток данных, который в состоянии отдать современный диск.", "Виртуальная машина как и реальная, активно использует диск только при загрузке.". 😛

Не, обычно оно мне за день надоедает.

Так не для себя же, других повеселить. 😀

И вообще, у меня бритва режет волос в сантиметре от пальцев, а "большие дяди" говорят надо в трех!

Переквалифицируйтесь в церюльника, глядишь и бритва будет брить как надо. 😀

Вот это волейбол!

Ждём ответного удара 😀

Я понимаю, сферический конь в вакууме облегчает полет фантазии, но как-то уж слишком откровенно пытаетесь отползти. Забавно, но не более.

Так я не отползаю, а абсолютно конкретно указываю на ваши ошибки, а вы из моих сообщений сочинения на вольную тему пишете. 😊

Ну и таки не стесняйтесь, продолжайте - кто из "работников ИТ сферы", к тому же админящий некий сервер, будучи не в состоянии оптимально настроить систему под задачу, начнет спрашивать чем дефрагментировать диск на оружейном форуме?

Какая-то бредовая логика получается, почему именно спрашивают, почему именно админящие некий сервер, и почему не в состоянии настроить систему под задачу? 😀 Кроме того, чего мне продолжать? Там во всей фразе моего только в кавычках, остальное ваши фантазии...

Таки цИрюльник, русский язык тоже не очень?

Ой стыдно-стыдно, все признаю, был не прав, фрагментации NTFS - не существует, самая тяжелая нагрузка на ДП - компиляция, а виртуалки и торренты не грузят ДП. 😀

А если серьезно, мелко плаваете. 😛

Сильно прошу не бить, прочитал ваш спор по диагонали, очень много незнакомых слов 😀

Из моей практики - дефрагментация на нынешнем этапе мало что дает. Ощутимого роста производительности нет. Ощутимый для меня это хотя бы на 30% быстрее стало. В последние полгода часто делал эту дефрагментацию, но не потому что реально нужно было, а от нефиг делать и смотрел результат. И что увидел - да, сразу после дефрагментации (особенно при очень сильно забитом винте) будет прирост, но через пару дней всё возвращается на круги своя (даже если освободить много места до дефрагментации). С секундомером конечно не засекал постоянно (один раз только было дело), но какого-то мега прироста производительности не увидел. Включение компа и полная загрузка всех нужных программ к примеру стала не 6-ть минут, а 5:45. Это ни о чем.

По поводу баз данных - я может путаю, давно с SQL не работаю, но как мне помнится дефрагментацию сторонними утилитами там запрещалось делать категорически. Дефрагментировать же рейд с кучей виртуальных машин внутри, тоже занятие сомнительное ИМХО.

badydoc

Андрей мы с вами уже говорили на тему дефрагментации и вроде сошлись на мнении, что все зависит от файловой структуры и нагрузки на диск. 😊 Кроме того, если бы вы не читали нашу полемику по диагонали, то знали, что дефрагментацию БД и вирутальных машин в рейд массивах никто не предлагал. По крайней мере я. Изначально все это было частью примеров, где я пытался на пальцах объяснить товарищу M.N.V, что сетевой интерфейс даже не высокой скорости далеко не всегда узкое горлышко, и что скорость чтения и записи данных на жесткий диск напрямую зависит от того как это происходит. Уж вам то этого не знать, если вы собирали сервак под 1C. Он за это дело благополучно зацепился, выдумал какую-то ахинею, приписал ее мне, и теперь хочет, чтобы я ее доказал. Понятное дело, что мне это не интересно. 😊 Замер прироста производительности от дефрагметации путем замера времени загрузки рабочей системы - не показателен. Смотреть нужно там где есть фрагментация, врядли системные файлы сильно фрагментированы. Для меня прирост виден в работе торрент клиента вируталок, массовой обработки большого числа файлов.

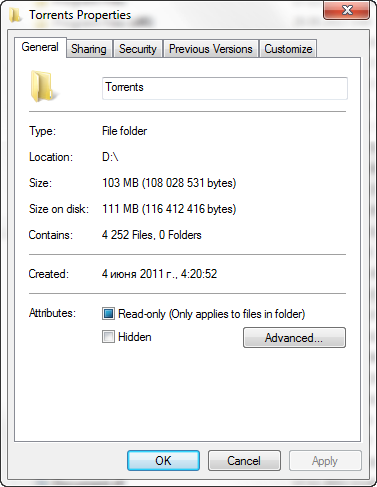

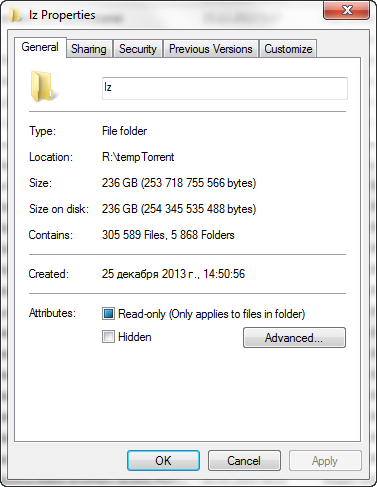

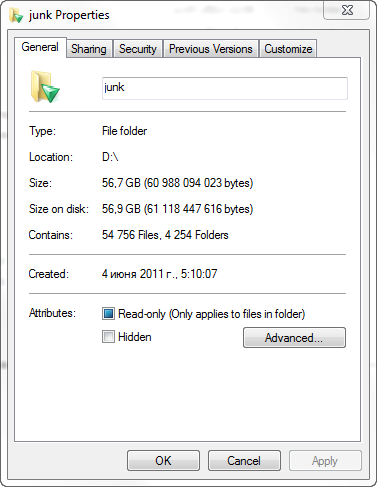

Для примера:

И таких папок у меня много, и операции над содержимом, включая раздачу через торрент, запись, или обработку, позволяет хорошо прочувствовать разницу до и после дефрагментации.

Ок. Год кончается, а наводящие вопросы не помогают, будем объяснять.

Разницу между IMHO и ИМХО объяснить?

Ну, все же, объяснение - это логически обоснованное изложение фактов, помогающие что-либо понять. В виду того, что ваши тирады слабо коррелируют со смысловой нитью моих сообщений, и местами лишены здравой логики, объяснением их назвать сложно. 😛 Скорее они больше похожи, на, как вы сами сказали, "тонны словесного поноса с эротическими фантазиями на отвлеченные темы". 😀

Тяжелые будни доморощенных админов, раздающих "огромное количество" SQL коннектов из-под виртуальных машин с единственного раздела домашних файлопомоек меня интересуют чуть менее чем никак, поскольку IMHO рукожопость не лечится.

Что значит доморощенных админов? Не знаю чем вы занимаетесь, но часто бывает, когда нужно отработать ситуацию до того, как будешь внедрять что-то у заказчика. Конкретно я использую вирутуалки с 2008r2, 2012, MacOS 10.8, 10.6, Windows XP, Windows 7, Windows 8, Ubuntu. И в этом нет ничего такого.

"Чуть менее" потому, что как этот мифический персонаж будет раз в неделю дефрагментировать раздел на пару терабайт, заполненный на 90%, посмотреть я бы хотел.

Не на 90 процентов, а на 50-70, и не раз в неделю, а раз в две. Впрочем, чего я в вашем словоблудии копаюсь, бессмыслица она и есть бессмыслица.

все высказанное человеком является его мнением, если он при этом не ссылается на чужое).

Вам наверное трудно понять, что мнение бывает объективным и субъективным, первое, при этом, не нуждается в ссылках на чужое мнение, и сильно отличается по качеству информационной нагрузки от второго, примерно как сигнал от шума.

Если у "работника ИТ сферы" человек явно от темы далекий спрашивает "чем дефрагментировать диск", то "работник ИТ сферы" должен бы уточнить, а почему собственно это требуется, поскольку в результате длинной увлекательной беседы мы вроде выяснили, что:

"Приложений именно зависящих от производительности дисковой подсистемы в принципе мало"

Напоминает, когда на просьбу "дать туалетную бумагу", начинают спрашивать - "зачем?". Если человеку нужен дефрагментатор, значит он ему нужен, что с ним делать он уже сам разберется. У W7 дефрагментатор по умолчанию включен и запускается для всех дисков, кроме SSD, где-то раз в неделю автоматом, что, достаточно четко описывает отношения Майкрософт к вопросу дефрагментации, и это отношение явно отлично от вашего. Более того, я не удивлюсь, если вы про это не знаете, и думаете, что у вас само по себе все так хорошо работает. 😀

Дополнительно, "работник ИТ сферы" должен бы уточнить процент фрагментации и заполнения раздела. Просто дабы убедиться, что дефрагментация действительно нужна и возможна.

Опять лирика, хочу я посмотреть, как вы будете оценивать на сколько мне нужна дефрагментация не знаю структуры фрагментированных участков диска и программы, с которой я получил процент фрагментации. Давайте подальше от теории, поближе к практике, попробуйте использовать различные дефрагментаторы, оцените их влияние на производительность, а потом вещайте свое "мнение" на эту тему. 😛

Если уж "работник ИТ сферы" почему-то советует сторонний дефрагментатор, то он должен бы хоть пару слов сказать о дефрагментации файла подкачки и MFT. Хотя бы просто потому, что фрагментация файла подкачки влияет на работу практически всех приложений, а фрагментация MFT влияет на все файловые операции.

Просто логически - какая связь между фрагментацией MFT и файла подкачки с тем, что, советуя сторонний дефрагментатор, нужно о ней говорить. Обоснуйте зачем? То есть вот я посоветовал сторонний дефрагментатор, и при этом мне обязательно нужно "хоть пару слов сказать о дефрагментации файла подкачки и MFT". Зачем? 😀

И собственно только из-за возможности дефрагментации этих двух областей имеет смысл применять сторонние продукты.

Опять лирика... А то что сторонние продукты могут двигать любые системные файлы, файлы и папки по выбору, просто обладают более эффективными алгоритмами работы и.т.д. - это не считается. Опять же, не нужно говорить о том, чем вы не пользовались. 😊

Про последовательное расположение файлов после дефрагментации "работник ИТ сферы" должен бы сказать, что это зависит от выбранного метода дефрагментации, и как минимум дефрагментация свободного места этого не гарантирует.

И какой смысл об этом говорить? Человек должен сам разбираться с режимами софта, который он будет использовать.

Достаточно глубоко?

Да-да, очень.... 😀

Goldheart2Да, я помню его. Именно по этому и стал проводить эксперименты с дефрагментацией. И как и писал выше особого смысла в ней не увидел. С кучей торрентов были машины (в том числе моя собственная), опять же какогото сверх ускорения работы после дефрагментации не заметил. Ну винт поменьше гудит, но скорость копирования (отдачи в торренте) не изменилась (ну или изменилась так незначительно, что это незаметно).

Андрей мы с вами уже говорили на тему дефрагментации и вроде сошлись на мнении, что все зависит от файловой структуры и нагрузки на диск.

Количество слов растет, но смысла больше не становится. Попытайтесь к примеру выяснить, когда запускается автоматическая дефрагментация, и какие файлы она дефрагментирует. Зачем дефрагментировать файл подкачки и MFT - если смысл написанного не понятен - есть гугл, поинтересуйтесь зачем они нужны. Про "более эфективные" режимы копирования файла - спасибо, поржал.

Про "проверку решений" разработчиком перед установкой заказчику под виртуальной машиной - ну я даже хз что к этому можно добавить, ПМСМ просто лютый п..дец.

И какой смысл об этом говорить? Человек должен сам разбираться с режимами софта, который он будет использовать.

А какой тогда смысл советовать ему софт? Старайтесь быть последовательным.

Ну и собственно человек вот не поленился, специально эксперименты проводил.

Именно по этому и стал проводить эксперименты с дефрагментацией. И как и писал выше особого смысла в ней не увидел.

И лично я не вижу смысла катать эту вату дальше.

Ну винт поменьше гудит, но скорость копирования (отдачи в торренте) не изменилась (ну или изменилась так незначительно, что это незаметно).

Так она вряд ли изменится, просто под тяжелой нагрузкой у вас винт не будет медным тазом накрываться, и под ней же не будет резких просадок по скорости. То что винт меньше хрустит - тому прямое доказательство. Кстати, на всякий случай, у вас на машине, которую вы брали за не дефрагментированную, автоматическая дефрагментация отрублена была?

Количество слов растет, но смысла больше не становится.

Я рад, что вы наконец это осознали, и будете впредь писать максимально лаконичные сообщения, потому что читать их утомляет... 😊

Попытайтесь к примеру выяснить, когда запускается автоматическая дефрагментация, и какие файлы она дефрагментирует.

Я и так в курсе. 😛

Про "более эфективные" режимы копирования файла - спасибо, поржал.

*С грустью* Да ради бога, только смех без причины - это точно не признак большого ума... 😞 У вас есть фрагментированные файлы разного размера, есть фрагментированное свободное пространство. Время дефрагментации всего этого хозяйства зависит от эффективности алгоритма программы выполняющей дефрагментацию, на пальцах, это - какие файлы и в каком порядке двигать. И если бы вы практически сталкивались с дефрагментаторами, то знали бы, что даже при одинаковой качественной составляющей процесса время у разных дефрагментаторов на одном и том же образе диска и одном и том же железе может сильно отличаться.

Про "проверку решений" разработчиком перед установкой заказчику под виртуальной машиной - ну я даже хз что к этому можно добавить, ПМСМ просто лютый п..дец.

Вы конкретно пишите, почему вам подобная практика кажется "лютым п..децом"? А то как обычно, "громко, но пусто". 😀 Я например в последний раз проверял какие rdp клиенты под Mac будут работать с виндовым терминальником с нужными мне настройками безопасности, и не нарушит ли чего обновление фраймворка на самописной софтине на другом сервере. 😛

Ну и собственно человек вот не поленился, специально эксперименты проводил.

Если вы про Бадидока, то скажем так, его мнение слегка ангажированное(примерно как мне не переубедить его, что на смартфоне и компьютере не обязателен антивирус, так же и с дефрагментацией), и я сильно сомневаюсь в его объективности(скорость загрузки системы и отдачи с торрент клиента не есть показатель прироста производительности в следствии дефрагментации, и это если абстрагироваться от чистоты эксперимента, которая у меня тоже вызывает сомнение). 😛 Да и самое важное, я как бы тоже не ленился и специально проводил эксперименты, причем скорее всего куда более точно(вряд ли кто-то из вас заморачивался с посекторным копированием данных, чтобы сравнить дефрагментаторы и влияние фрагментации в разных условиях.) 😊

Goldheart2ну тфу-тфу-тфу давненько умерших винтов не встречал (не считая собственноручно сломанного - одна штука, и второй со стола упал). Бэды конечно были, порушенные файловые системы тоже, даже сдохший контроллер в НАС-е был. А вот чтобы под нагрузкой сдох вообще - не было давненько.

Так она вряд ли изменится, просто под тяжелой нагрузкой у вас винт не будет медным тазом накрываться, и под ней же не будет резких просадок по скорости. То что винт меньше хрустит - тому прямое доказательство. Кстати, на всякий случай, у вас на машине, которую вы брали за не дефрагментированную, автоматическая дефрагментация отрублена была?

Goldheart2да, 90% экспериментов проходили на винХР, так что дефрагментация там никогда не производилась. Были и на 7-ке эксперименты, но там если честно я не в курсе была ли настроена автоматическая дефрагментация.

автоматическая дефрагментация отрублена была?

Goldheart2Савва, ну вот не надо так 😊 Это нечестно и неправда. Я исхожу из собственного опыта. Увижу, что дефрагментация к примеру ускорило работу компа - напишу и буду другим советовать. Глупо же отрицать очевидное правда? Я же не спорю, что система с SSD диском быстрее обычной? 😛 А получается, что я вру и на самом деле после каждой дефрагментации система прям летать начинала, но я продолжаю врать, лишь бы не признать свою неправоту.

Если вы про Бадидока, то скажем так, его мнение слегка ангажированное(примерно как мне не переубедить его, что на смартфоне и компьютере не обязателен антивирус, так же и с дефрагментацией)

Goldheart2ну я обычный практик - приносят мне комп, говорят тупит. Ну окей - могу сразу всё снести и по новой поставить, могу денек посидеть и позапускать всякие чистелки реестра (или вручную почищу), сжатие там, дефрагментацию и прочие ускорители. И я это периодически делаю. И говорю вам вполне честно - ни разу не заметил какой-то особой разницы до и после дефрагментации. 1С как работает, так и работает, комп загружается столько же, Автокад открывает проекты также как открывал. Что мне еще посмотреть? А главное что клиенту сказать? Мол ты не думай - я всё правильно делаю, но ты просто этого не видишь? 😊

скорость загрузки системы и отдачи с торрент клиента не есть показатель прироста производительности

з.ы. а про антивирус на андройде я же вроде писал - я его советую ставить всем, кто нифига в компах не шарит, чтобы он им всякую чушь не давал скачать и установить, да по ссылкам левым не пускал. И нигде не утверждал, что андройд(да и винда) без антивиря это плохо и неправильно. Про каспер я соответственно пишу тоже из собственной практики (хотя конечно они мне за каждый хвалебный отзыв башляют кучу денег 😀) - вот приносят мне некоторые товарищи ноут свой раз в месяц (а на нем скажем аваст стоит), ставлю им нод32 - смотрю опять приносят, ставлю антивирь от микрософта, опять приносят. Ставлю каспера - опа, перестали носить. Какой вывод? 😊

З.З.Ы. кстати, вот щаз у меня под рукой есть сильно замусоренный торрентами 1Тб винт, занятый примерно на половину. Могу по вашим рекомендациям провести эксперимент и выложить результаты, благо время есть свободное 😛

ну тфу-тфу-тфу давненько умерших винтов не встречал (не считая собственноручно сломанного - одна штука, и второй со стола упал). Бэды конечно были, порушенные файловые системы тоже, даже сдохший контроллер в НАС-е был. А вот чтобы под нагрузкой сдох вообще - не было давненько.

Я не про умершие или с посыпавшийся поверхностью, я про то, когда диск перегружается с характерным графиком в счетчике производительности.

Были и на 7-ке эксперименты, но там если честно я не в курсе была ли настроена автоматическая дефрагментация.

Принципиальный момент, потому что там она по умолчанию врублена для всего кроме SSD.

А получается, что я вру и на самом деле после каждой дефрагментации система прям летать начинала, но я продолжаю врать, лишь бы не признать свою неправоту.

Не, не так, дело не во лжи, а в чистоте эксперимента и его корректности, и вашем не желании соблюдать его чистоту и проводить его корректно. Ну сами подумайте, не известно количество свободного пространства на диске, дефрагментатор, структура данных, включена/не включена автодефрагментация, какое чтение запись выполнялись и.т.д.?

Все эти рассуждения сильно напоминают старый анекдот:

- Не понимаю, почему люди так восхищаются этим Карузо? Косноязычен, гугнив, поёт - ничего не разберёшь!

- А вы слышали, как поёт Карузо?

- Да, мне тут кое-что из его репертуара Рабинович напел по телефону.

И говорю вам вполне честно - ни разу не заметил какой-то особой разницы до и после дефрагментации. 1С как работает, так и работает, комп загружается столько же, Автокад открывает проекты также как открывал. Что мне еще посмотреть? А главное что клиенту сказать? Мол ты не думай - я всё правильно делаю, но ты просто этого не видишь?

Вы начните с того, что скажите, вы папки с аналогичным количеством файлов и объемом, как у меня, видели или нет? Можно и дальше эту ветвь развить, какой автокад, при каком объеме свободного пространства на диске, какие проекты, автобэк как работает? Понимаете, я не теоретик, и практически всякое повидал, поэтому ваши рассуждения для меня полная абстракция. Я не исключаю, что конкретно у вас может быть все замечательно, но если бы мы были территориально рядом, я бы без проблем вам бы показал как оно еще бывает. 😛

Про каспер я соответственно пишу тоже из собственной практики

Но возводить, собственную практику в некий абсолют - не правильно, как минимум. Тут вон выкладывали, как Каспер грохнул на компах tcpip.sys, это далеко не единственный случай, когда он лажал, про эпизод с почтовой БД я писал. Про то, как он пропускал вири известно тоже не только мне. А вы все продолжаете не верить и говорить, что практически с этим не встречались. Пожалуйста, только когда встретитесь - по-другому запоете. 😛

З.З.Ы. кстати, вот щаз у меня под рукой есть сильно замусоренный торрентами 1Тб винт, занятый примерно на половину. Могу по вашим рекомендациям провести эксперимент и выложить результаты, благо время есть свободное

Проведите его сами, возьмите много средних фрагментированных файлов и устройте их рандомное чтение. Сделайте дефрагментацию, еще раз запустите рандомное чтение. Сравните результаты.

Goldheart2ну если я не вижу, как это влияет на работу - мне всё равно 😛

Я не про умершие или с посыпавшийся поверхностью, я про то, когда диск перегружается с характерным графиком в счетчике производительности.

Goldheart2ну на ХР она точно не врублена, там такого не было

Принципиальный момент, потому что там она по умолчанию врублена для всего кроме SSD.

Goldheart2для меня показатель эффективности - результат. Помогло или нет. Так вот - дефрагментация мне не помогла ни разу улучшить производительность. Выборка в масштабах вселенной конечно недостаточная (машин 20 за полгода), но лично для меня достаточная. Замена обычного диска на SSD - помогает, это видно. Убрать всё лишнее из автозагрузки - тоже видно. Добавить оперативы - опять видно. А вот с дефрагментацией - не видно.

Не, не так, дело не во лжи, а в чистоте эксперимента и его корректности

Goldheart2это шутка такая? 350 гигов? Да нет, что вы! Да никогда в жизни не видел таких объемов 😀

Вы начните с того, что скажите, вы папки с аналогичным количеством файлов и объемом, как у меня, видели или нет?

Goldheart2ну щаз есть такие штуки как скайп с показам удаленного рабочего стола, есть тимвьювер и прочие проги. Так что было бы желание 😛

Я не исключаю, что конкретно у вас может быть все замечательно, но если бы мы были территориально рядом, я бы без проблем вам бы показал как оно еще бывает.

Goldheart2а я что говорю, что есть только одно правильное мнение и это мое мнение? спрашивают - советую. Ставлю ИМХО даже. Где ж абсолют? Пройдет сколько то времени, будут косяки у каспера и поднимется скажем аваст - буду его советовать.

Но возводить, собственную практику в некий абсолют - не правильно, как минимум.

Goldheart2ну вообще-то случай таки единичный, ибо затрагивал лишь малую долю компов с вин7 х86. И у меня лично ни один клиент под это дело не попал. Да и у других антивирей такая херня тоже бывает.

Тут вон выкладывали, как Каспер грохнул на компах tcpip.sys, это далеко не единственный случай

По поводу базы данных опять же - он ПРЕДЛАГАЕТ ее удалить. А никак не удаляет сразу и безвозвратно. И таки да, у меня такая же херня была с другим антивирем.

Goldheart2ну Савва, прекращайте уже 😛 Где я говорил, что каспер настолько гениальный антивирь, что вообще всё ловит. Ни одну заразу не пропускает? Где? Не было такого. Пропускает, все пропускают. Вот только каспер пропускает поменьше заразы, чем все остальные.

Про то, как он пропускал вири известно тоже не только мне. А вы все продолжаете не верить

Goldheart2можете мне поверить, но практики у меня - попой кушай 😊 Хотите сравнить? Ну не вопрос - сколько компов вы обслуживаете? 😛

Пожалуйста, только когда встретитесь - по-другому запоете.

Goldheart2не-не-не, так не пойдет. Вы мне четкую инструкцию напишите, что и как сравнивать, как копировать и т.д. - тогда сравню. А то я то скопирую сначала папку с мильенов файлов на другой диск (эксперимент 1), потом скопирую папку с одним файлом но размером в 10Гиг (эксперимент 2) - сравню эти показатели до и после дефрагментации, окажется, что разница скажем пару секунд при общем времени копирования в пару часов. А вы скажете, что я неправильно всё делал 😊

Проведите его сами, возьмите много средних фрагментированных файлов и устройте их рандомное чтение. Сделайте дефрагментацию, еще раз запустите рандомное чтение. Сравните результаты.

badydoc

В качестве примера.

Эксперимент:

Имеется диск: емкость 1.81 TB, использовано 453 GB.

Имеется папка с файлами: занимает 8.48 GB, внутри 3445 папки, содержащие 50459 файлов. Папка была перенесена на этот диск копированием с другого диска. При анализе PD показал наличие фрагментации этой папки, точнее ее содержимого. Специально до дефрагментации решил сделать торрент файл к этой папке, операция заняла 1 минуту 38 секунд. Сделал дефрагментацию с помощью PD. Повторное создание торрент файла заняло уже 1 минуту ровно.

ну если я не вижу, как это влияет на работу - мне всё равно

Андрей, если у вас будет подобная перегрузка диска, поверьте, вы не только увидите, вы это почувствуете. 😀

для меня показатель эффективности - результат. Помогло или нет. Так вот - дефрагментация мне не помогла ни разу улучшить производительность. Выборка в масштабах вселенной конечно недостаточная (машин 20 за полгода), но лично для меня достаточная. Замена обычного диска на SSD - помогает, это видно. Убрать всё лишнее из автозагрузки - тоже видно. Добавить оперативы - опять видно. А вот с дефрагментацией - не видно.

Я же сказал, это разговор ни о чем, и речь не о количестве машин. Запуск ворда с большой вероятностью быстрее не станет от дефрагментации. 😛

это шутка такая? 350 гигов? Да нет, что вы! Да никогда в жизни не видел таких объемов

Чувствуется, что вы слабо понимаете, в чем там изюминка. 😀 Дело не в объеме, а в соотношении объема к КОЛИЧЕСТВУ файлов. Опять же заметно, что вам никогда не приходилось копировать или удалять или обрабатывать большое, действительно большое, количество файлов, знали бы тогда, что там очень круто проседает производительность диска, что вполне логично, учитывая его устройство.

ну щаз есть такие штуки как скайп с показам удаленного рабочего стола, есть тимвьювер и прочие проги. Так что было бы желание

И желания как раз нет, я не миссия, чтобы заниматься вашим просвещением. Одно дело показать засраную машину в живую, и показать результат до и после, другое специально создать у себя на машине фрагментацию, договорится с человеком из другого города о сеансе связи, запустить его и показать ему это.

По поводу базы данных опять же - он ПРЕДЛАГАЕТ ее удалить. А никак не удаляет сразу и безвозвратно. И таки да, у меня такая же херня была с другим антивирем.

Предлагает - это смотря как его настроить, да и вообще какого он ее в принципе предлагает удалить...?

можете мне поверить, но практики у меня - попой кушай Хотите сравнить? Ну не вопрос - сколько компов вы обслуживаете?

Андрей, давайте без пенисометрии... 😊 А то я спрошу, какие вы операционки обслуживаете, сколько из них серверных и с какими ролями, сколько систем видео наблюдения настроили, с какой орг-техникой имели дело и.т.д.? 😛

Я верю, что практики у вас достаточно, но также я верю, что у вас она достаточно узконаправленная.

не-не-не, так не пойдет. Вы мне четкую инструкцию напишите, что и как сравнивать, как копировать и т.д. - тогда сравню.

Слишком длинная инструкция получится. Пример эксперимента выше. Хотя я уже представляю, как вы его сделаете, возьмете папку с отсутствующей фрагментацией, создадите по ней торрент, сделаете дефрагментацию, еще раз создадите торрент и радостно отрапортуете, что разницы нет. 😛

Goldheart2хорошо, запуск чего даст это почувствовать? 😛

Я же сказал, это разговор ни о чем, и речь не о количестве машин. Запуск ворда с большой вероятностью быстрее не станет от дефрагментации.

Goldheart2вы ошибаетесь 😛

Дело не в объеме, а в соотношении объема к КОЛИЧЕСТВУ файлов. Опять же заметно, что вам никогда не приходилось копировать или удалять или обрабатывать большое, действительно большое, количество файлов, знали бы тогда, что там очень круто проседает производительность диска, что вполне логично, учитывая его устройство.

Goldheart2при чем тут просвещение? У нас вышел небольшой спор - я готов пойти на эксперимент, так в чем проблема? 😛

И желания как раз нет, я не миссия, чтобы заниматься вашим просвещением. Одно дело показать засраную машину в живую, и показать результат до и после, другое специально создать у себя на машине фрагментацию, договорится с человеком из другого города о сеансе связи, запустить его и показать ему это.

Goldheart2на стандартных настройках каспер спрашивает что делать 😛

Предлагает - это смотря как его настроить, да и вообще какого он ее в принципе предлагает удалить...?

Goldheart2ну опять же - почему вы мне этот вопрос задаете? я не сотрудник лаборатории касперского. Разместите у них на форуме свою проблему, если вам действительно так важен ответ на ваш вопрос.

да и вообще какого он ее в принципе предлагает удалить...?

Goldheart2а почему нет, Савва? я ссылаюсь на свой опыт, вы его ставите под сомнение. Так давайте сравним, чья выборка больше?

Андрей, давайте без пенисометрии... А то я спрошу, какие вы операционки обслуживаете, сколько из них серверных и с какими ролями, сколько систем видео наблюдения настроили, с какой орг-техникой имели дело и.т.д.? Я верю, что практики у вас достаточно, но также я верю, что у вас она достаточно узконаправленная.

Goldheart2ну вот тока грязи не надо.

Слишком длинная инструкция получится. Пример эксперимента выше. Хотя я уже представляю, как вы его сделаете, возьмете папку с отсутствующей фрагментацией, создадите по ней торрент, сделаете дефрагментацию, еще раз создадите торрент и радостно отрапортуете, что разницы нет.

Итак папка: Файлов: 529 109; папок: 33 999, размер 298 ГБ - торрент файл создавался 1.55 минуты. Сейчас запустил дефрагментацию всего диска, завтра посмотрим за сколько создаться.

Goldheart2Ну вы много чего пишите, так что уж снизойдите и в двух-трех словах напишите.

Я уже писал, много раз, читайте ветку внимательно.

Goldheart2Вы делаете неправильные выводы из-за недостатка информации, а виноват я? Самокритично 😊

Тогда не пишете глупости и я не буду "ошибаться".

Goldheart2А кто их такими сделал? Тот и виноват и нече на антивирь тогда пинять. Я любой антивирь также настрою, что он на любой чих будет удалять все и сразу. Антивирь виноват будет?

А если они не стандартные?

Goldheart2Какой вы Савва однако непоследовательный, не по нашему это, не по инженерному. Времени тут отвечать огромными сообщениями - у вас полно, а как до эксперимента дошло, так времени нет и отсылки на мой небогатый опыт. Так проиграть боитесь? Не бойтесь, в этом ничего зазорного нет, все ошибаются. Только вот грамотный человек признает, что он неправ был. А кто-то будет до следующего года обвинять аппонентов во всех смертных грехах.

Потому что, Андрей, мне минимум жалко на это времени

badydocпосле дефрагментации - 1.38. Как по мне разница в 17 секунд - незначительна 😊

ну вот тока грязи не надо. Итак папка: Файлов: 529 109; папок: 33 999, размер 298 ГБ - торрент файл создавался 1.55 минуты. Сейчас запустил дефрагментацию всего диска, завтра посмотрим за сколько создаться.

Ну вы много чего пишите, так что уж снизойдите и в двух-трех словах напишите.

В том то и дело, что много и по многу раз одно и то же, честно уже надоело. 😊

А кто их такими сделал? Тот и виноват и нече на антивирь тогда пинять. Я любой антивирь также настрою, что он на любой чих будет удалять все и сразу. Антивирь виноват будет?

С этим я не спорю, но почему имея одно зараженное письмо он хочет прибить всю базу? Разработчик должен закладывать в фунционал защиту от дурака, потому что, в общем, антивири и рассчитаны обычных пользователей, повер юзерам и профессионалам ИТ они в резидентном режиме не нужны.

Какой вы Савва однако непоследовательный, не по нашему это, не по инженерному. Времени тут отвечать огромными сообщениями - у вас полно, а как до эксперимента дошло, так времени нет и отсылки на мой небогатый опыт.

Андрей не надо пытаться манипулировать моими словами и брать меня на "слабо", я думаю понятно, что это бесполезно. И никакой непоследовательности в том, что я пишу или делаю - нет. У меня действительно нет времени, желания на выяснения у кого из нас какая выборка, и на прочие соревнования из серия кто выше на стенку помочится. Я четко это написал. Правда, вы процитировав мое сообщение почему-то подняли тему эксперимента, хотя это был ответ именно на "а почему нет, Савва? я ссылаюсь на свой опыт, вы его ставите под сомнение. Так давайте сравним, чья выборка больше?". Тем самым как бы случайно исказив общий смысл... Что до самого экспиремента вот наш диалог:

-Могу по вашим рекомендациям провести эксперимент и выложить результаты, благо время есть свободное

+Проведите его сами, возьмите много средних фрагментированных файлов и устройте их рандомное чтение. Сделайте дефрагментацию, еще раз запустите рандомное чтение. Сравните результаты.

-не-не-не, так не пойдет. Вы мне четкую инструкцию напишите, что и как сравнивать, как копировать и т.д. - тогда сравню. А то я то скопирую сначала папку с мильенов файлов на другой диск (эксперимент 1), потом скопирую папку с одним файлом но размером в 10Гиг (эксперимент 2) - сравню эти показатели до и после дефрагментации, окажется, что разница скажем пару секунд при общем времени копирования в пару часов. А вы скажете, что я неправильно всё делал

+Слишком длинная инструкция получится. Пример эксперимента выше. Хотя я уже представляю, как вы его сделаете, возьмете папку с отсутствующей фрагментацией, создадите по ней торрент, сделаете дефрагментацию, еще раз создадите торрент и радостно отрапортуете, что разницы нет

ну вот тока грязи не надо.

-Итак папка: Файлов: 529 109; папок: 33 999, размер 298 ГБ - торрент файл создавался 1.55 минуты. Сейчас запустил дефрагментацию всего диска, завтра посмотрим за сколько создаться.

И где тут про то, что у меня нет времени или что-то подобное. Вы хотели рекомендации - вам их дали. Писать больше я не хочу, того, что написано уже достаточно. Да и много я уже написал. Просто есть ощущение того, что мои силы тратятся впустую. Вы все время занимаете такую позицию, что вам что-то должны доказывать. Почему? Проявляется это в поверхностной-сомнительной аргументации(вспомним попытку мерить эффект от дефрагментации через скорость отдачи торрент клиента), абстрактном("ну я обычный практик - приносят мне комп, говорят тупит......И говорю вам вполне честно - ни разу не заметил какой-то особой разницы до и после дефрагментации.") описании условий при которых были получены результаты, и полном не желании внимательно читать, что вам пишет собеседник(вспомним фразу про дефрагментацию БД и дисков в массиве). Я этим заниматься не хочу.

Только вот грамотный человек признает, что он неправ был. А кто-то будет до следующего года обвинять аппонентов во всех смертных грехах.

Во-о-от, что вам мешает спокойно признать собственную неправоту - мне не понятно.

ну вот тока грязи не надо. Итак папка: Файлов: 529 109; папок: 33 999, размер 298 ГБ - торрент файл создавался 1.55 минуты. Сейчас запустил дефрагментацию всего диска, завтра посмотрим за сколько создаться.

...

после дефрагментации - 1.38. Как по мне разница в 17 секунд - незначительна

Вот о чем и пишу, где вводные данные? Чем дефрагментировали, сколько свободного пространства на диске, фрагментированы ли данные? А ведь все это было в том, что описал я, а вы этого повторить не можете, скорее не хотите, но хотите, чтобы вам я писал подробные инструкции, чтобы потом класть на них большой болт. 😞

P.S. Не, Андрей, продолжайте дальше этот цирк без меня...

Goldheart2Защиту от дурака вы успешно сами и отключили, сменив настройки. А то следуя вашей логике - надо и кнопочку Del,отключить. А то вдруг ее кто-то нажмет не подумав и удалит базу.

Разработчик должен закладывать в фунционал защиту от дурака

Goldheart2Вот интересный вы товарищ Савва. Вводные данные я написал, вы видимо невнимательно читали. Винт террабайт, забит на половину (600гиг примерно), дефрагментировал конечно PD. Ну и какие вам еще данные нужны были? Размер папки и число файлов тоже указано выше.

Вот о чем и пишу, где вводные данные?

Вот интересный вы товарищ Савва. Вводные данные я написал, вы видимо невнимательно читали. Винт террабайт, забит на половину (600гиг примерно), дефрагментировал конечно PD. Ну и какие вам еще данные нужны были? Размер папки и число файлов тоже указано выше.

Андрей, я не телепат, если у вас и было в мыслях написать вводные, то вы этого не сделали. Ниже цитата из вашего сообщения

Итак папка: Файлов: 529 109; папок: 33 999, размер 298 ГБ - торрент файл создавался 1.55 минуты. Сейчас запустил дефрагментацию всего диска, завтра посмотрим за сколько создаться.

И где тут про объем винта, дефрагментатор и.т.д?

Дефрагментатор - PD, уже хоть что-то сказали, а режим дефрагментации какой, а то их там минимум 4-и? Изначальная фрагментация? Ладно, можете не отвечать...

Goldheart2Про объем винта я писал ранее. Выбор дефрагментатора помому очевиден - какой смысл в эксперименте, если бы я его штатным делал? Режим завтра гляну, как до дома доберусь. Фрагментация естественно присутствовала.

И где тут про объем винта

Про объем винта я писал ранее.

Где?

Выбор дефрагментатора помому очевиден - какой смысл в эксперименте, если бы я его штатным делал?

Дефрагментаторов в принципе не мало, поэтому не очевиден, вы могли взять любой приглянувшийся.

Фрагментация естественно присутствовала.

Вопрос в том, на сколько.

Goldheart2Пост номер 67 на предыдущей страничке.

Где?

Goldheart2А по моему вполне очевидно, что проги для сравнения стоит выбирать одинаковые.

поэтому не очевиден

Пост номер 67 на предыдущей страничке.

Знать точно, что это один и тот же винт можете только вы.

А по моему вполне очевидно, что проги для сравнения стоит выбирать одинаковые.

И почему я не удивлен.

Goldheart2Вот это поворот 😊 ну конечно, я сначала пишу про один винт, потом беру другой, время засекаю вообще по случайным роликам в ютубе, а дефрагментацию вообще не делал.

Знать точно, что это один и тот же винт можете только вы

Да и режим дефрагментации так и называется - дефрагментация 😊 версия у меня русская, так что не знаю как он там по аглицки назван, но думаю аналогично.

Вот это поворот 😊 ну конечно, я сначала пишу про один винт, потом беру другой, время засекаю вообще по случайным роликам в ютубе, а дефрагментацию вообще не делал.

Вот не надо ерничать, откуда я знаю про какой винт вы пишите? И главное почему я должен гадать? Я пишу вводные сразу и конкретно, вы этого не делаете, что наводит на определённые мысли. 😛

Вы можете от и до написать, что и как вы делали с компьютером или это непосильная задача? 😀 Только не надо рассказывать, что вам и на это нужна инструкция. 😀

Goldheart2Ну не знаю откуда, наверное из моих сообщений. Которые, признайтесь, вы тоже прочитали по диагонали, и упустили мысль.

Вот не надо ерничать, откуда я знаю про какой винт вы пишите?

Goldheart2От чего же нет? Есть у меня резервный винт со старого компа, на нем в оновном лежали торрент файлы (процентов 80) и всякий мусор типа свежих дистрибутивов, фоток и так далее. Винт стоял на машине с винХР, дефрагментация никогда не проводилась. Винт сильно замусорен, так как торренты скачивались и удалялись с завидным постоянством. Потом он полгода валялся у меня в столе и никто его не трогал. После нашего спора я подключил его к компу с вин7, убедился что дефрагментация по рассписанию не произойдет в ближайщие пару дней, создал торрент файл как вы просили, скачал перфектдиск, запустил, выбрал нужный диск и нажал кнопку старт. После чего пошел спать. На следующий день убедился, что дефрагментация завершена создал торрент файл по новой. Время засекал секундомером на телефоне. Какие еще данные нужны?

Вы можете от и до написать,

Ну не знаю откуда, наверное из моих сообщений. Которые, признайтесь, вы тоже прочитали по диагонали, и упустили мысль.

Не думаю. Как вы заметили, я очень внимательно читаю то, что вы пишете. 😛

Какие еще данные нужны?

Да не нужны они мне, я все надеялся, что вы заметите свои ошибки в тестировании, но чувствую это без толку.

http://sendfile.su/919904 - видео с дефрагментацией образа виртуальной машины и ее загрузкой до и после. Образ не сильно фрагментирован, диск не засран. Впрочем там и так все показано. Надеюсь после этого, мы закончим эту бессмысленную беседу. 😀

Goldheart2Ну Савва, умейте признавать свои ошибки. А то ваше "не думаю" после того, как вы не заметили что я уже писал про свой винт как-то неубедительно звучит.

Не думаю

Goldheart2Ну так скажите, мол так и так надо было делать, а не вот так и так. А вы виляете всё. Сами предложили вариант с торрентами, теперь с чегото решили виртульную машину дефрагментировать.

что вы заметите свои ошибки в тестировании

Goldheart2видео интересное 😊 особенно прикольно прога определяет назасранность диска - мне по картинке выданное ПД например кажется что он сильно фрагментирован. ИЛи для сильнозасран надо чтобы все кусочки были равномерно по всей поверхности диска были размазаны? Но это так, к слову. А суть не в этом, разница в скорости загрузки всего 10 секунд (50 и 40 секунд соответственно). Разница как мы видим не сильно большая и явно не 30% про которые я писал. Вот если б после дефрагментации винда загрузилась бы секунд за 25-30 - это был бы успех. И кстати интересно сохранится ли этот результат в 40 секунд через недельку плотной работы с этим винтом.

http://sendfile.su/919904

Ну Савва, умейте признавать свои ошибки. А то ваше "не думаю" после того, как вы не заметили что я уже писал про свой винт как-то неубедительно звучит.

А что, простите, не убедительно звучит? 😀 То, что вы в самой вводной своего "эксперимента" не указали эти данные...? Я же вам написал, что то, что вы где-то упомянули свой винт, не говорит о том, что это именно тот hdd, который использовался в эксперименте. Это очевидно, любой человек когда публикует результаты бенчмарка, если он не хочет, чтобы его освистали, всегда пишет вводную перед самими результатами, а не как вы - что-то где-то невзначай упомянули.... 😛

видео интересное ....... И кстати интересно сохранится ли этот результат в 40 секунд через недельку плотной работы с этим винтом.

Я был о вас лучшего мнения... Впрочем, чего-то подобного ожидал. Давайте последовательно разберем:

особенно прикольно прога определяет назасранность диска - мне по картинке выданное ПД например кажется что он сильно фрагментирован. ИЛи для сильнозасран надо чтобы все кусочки были равномерно по всей поверхности диска были размазаны? Но это так, к слову.

Андрей, если вам что-то кажется - креститесь, и может быть, оно исчезнет. 😀

Для кого я статистику PD показывал, там же все четко написано, что называется для дураков, File fragmentation, MFT fragmentation, Free space fragmentation, Largest free space chunk и.т.д. Переводить надеюсь не нужно? 😊 По факту, на этом диске фрагментирован только образ виртуальной машины несколько свежих фильмов, дырка в карте образовалась, потому что я удалил пару очень объемных папок и файлов с диска.

А суть не в этом, разница в скорости загрузки всего 10 секунд (50 и 40 секунд соответственно). Разница как мы видим не сильно большая и явно не 30% про которые я писал. Вот если б после дефрагментации винда загрузилась бы секунд за 25-30 - это был бы успех.

Даже если считать по-вашему, то между 50 и 40 - 20% или 25% разницы, в зависимости от того, что брать за основу, что уже не мало. Но мы не будем считать по-вашему, а будем считать правильно. 😀 Думаете я просто так повесил диспетчер задач в автозагрузку!? 😛 Естественно нет, там есть замечательная графа - "время работы", которая позволяет достаточно точно оценивать разницу во времени загрузки системы до и после, чтобы не вмешивать сюда время инициализации VMware и тому подобное. Так вот, до дефрагментации лучшее стартовое "время работы" - 39 секунд, а после 29 секунд, что дает нам 34% разницы или 25% в зависимости от того что взять за основу. Это уже больше подходит под "30% про которые я писал". Но это всего лишь пример, не показывающий в полной мере, что происходит с виртуалкой, если ее образ фрагментирован, проседает не только загрузка, проседают все операции так или иначе требующие работы с диском, проще говоря, тормозит все, и особенно запись. Если образ фрагментирован еще сильнее, а то, что я вам показал - это слабая фрагментации с большими кусками сводободного места на диске - то работать вообще не возможно.

И кстати интересно сохранится ли этот результат в 40 секунд через недельку плотной работы с этим винтом.

Если именно работать, то безусловно сохранится. Кстати, а почему вы спрашивайте? Вы же тут чуть ли не пяткой себя в грудь бьете, утверждаете, что дефрагментация - ерунда, что провели черте сколько экспериментов и.т.д...

Ну так скажите, мол так и так надо было делать, а не вот так и так. А вы виляете всё. Сами предложили вариант с торрентами, теперь с чегото решили виртульную машину дефрагментировать.

Зачем мне вам разжевывать вещи, очевидные для любого профессионала. Ну например, что между первым и вторым созданием торрент файла должна быть перезагрузка системы, или любой другой известный вам способ скинуть кэш, иначе даже без дефрагментации создания торрент файла будет идти значительно быстрее, куда быстрее, чем вы выше написали. Что опять же, учитывая тот факт, что вы об этом даже не обмолвились, наводит на мысль о неправдивости написанного вами выше. Это же и ответ вам на вопрос с чего я начал дефрагментировать виртуальную машину, просто потому, что делать видео захват с перезагрузкой - не особо хорошая идея, вы потом привяжетесь мол "я ссд подрубил во время обрыва записи"... 😀

Goldheart2не передергивайте, я написал что готов на эксперимент и у меня есть такой-то винт, потом спросил чего делать.

А что, простите, не убедительно звучит? То, что вы в самой вводной своего "эксперимента" не указали эти данные...?

Goldheart2а вот теперь вы из меня пытаетесь изобразить телепата. Где в вашем видео хоть что-то о том, что вы делали с винтом и какие файлы на нем лежат? Откуда я могу догадаться отчего "дырка" образовалась. Я вижу что до дефрагментации есть огромные разрывы, после их нет. Это очевидно любому. Как они там изначально появились - вам виднее. И соответственно мой вопрос о том, что будет с винтом через неделю при активной работе с ним - вполне имеет право на жизнь. И не очень понятно, что именно вас в нем смущает.

По факту, на этом диске фрагментирован только образ виртуальной машины несколько свежих фильмов, дырка в карте образовалась, потому что я удалил пару очень объемных папок и файлов с диска.

Goldheart2вам немало, мне мало. Вот разница между вашими 40 секундами и скажем загрузкой с моего SSD в 10 секунд - это да, разница есть и разница заметная. У вас она если и заметна то чутчуть. Или если б у вас винда до операции загружалась скажем 15 минут, а после стала загружаться 10. Это существенно. 5 минут это заметно.

Даже если считать по-вашему, то между 50 и 40 - 20% или 25% разницы, в зависимости от того, что брать за основу, что уже не мало.

Goldheart2ну к цифрам не надо придираться, я засекал от нажатия вами кнопки запуска винртульаной машины, что как мне видится особой роли не играет, накиньте недостающие 10 секунд и получите полученный мной результат.

39 секунд, а после 29 секунд

Goldheart2а вот с этого места давайте я повторю вопрос - с чего вы вдруг отказались от примера с торрентами и перекинулись на виртуалку?

Но это всего лишь пример, не показывающий в полной мере, что происходит с виртуалкой, если ее образ фрагментирован, проседает не только загрузка

Goldheart2ну вот попробуйте залить еще кучу фалов на винт свой, потом увеличить объем выделенный под виртуалку. Посмотрим результаты 😛

Если именно работать, то безусловно сохранится.

Goldheart2я про это написал вроде, опять пропустили? 😊 Я повторю - у меня были случаи, что ускорение в работе системы было в течении пары дней, а потом всё возвращалось на круги своя.

Вы же тут чуть ли не пяткой себя в грудь бьете, утверждаете, что дефрагментация - ерунда, что провели черте сколько экспериментов и.т.д...

Goldheart2а вот тут вы Савва пальцем в небо попали со своей телепатией 😀 Кнопочку "автоотключение" компа по завершению дефрагментации я таки поставил. Уж извините не стал писать об этом, так как значения не придал (да и вы могли бы написать как всё-таки по вашему правильно надо эксперимент проводить, а не пытаться меня подловить на неправильных действиях).

Зачем мне вам разжевывать вещи, очевидные для любого профессионала. Ну например, что между первым и вторым созданием торрент файла должна быть перезагрузка системы, или любой другой известный вам способ скинуть кэш, иначе даже без дефрагментации создания торрент файла будет идти значительно быстрее, куда быстрее, чем вы выше написали.

не передергивайте, я написал что готов на эксперимент и у меня есть такой-то винт, потом спросил чего делать.

Я и не передергивая, моя мысль изложена выше достаточно доходчиво, повторять ее не вижу смысла.

а вот теперь вы из меня пытаетесь изобразить телепата. Где в вашем видео хоть что-то о том, что вы делали с винтом и какие файлы на нем лежат? Откуда я могу догадаться отчего "дырка" образовалась. Я вижу что до дефрагментации есть огромные разрывы, после их нет. Это очевидно любому.

Все же не любому... Для человека, умеющего читать статистику PD данных на видео достаточно.

И соответственно мой вопрос о том, что будет с винтом через неделю при активной работе с ним - вполне имеет право на жизнь. И не очень понятно, что именно вас в нем смущает.

Ничего не будет, я уже вроде ответил на него.

вам немало, мне мало. Вот разница между вашими 40 секундами и скажем загрузкой с моего SSD в 10 секунд - это да, разница есть и разница заметная. У вас она если и заметна то чутчуть. Или если б у вас винда до операции загружалась скажем 15 минут, а после стала загружаться 10. Это существенно. 5 минут это заметно.

Я не понимаю о чем вы говорите, применительно к VM, и в отличие от обычной системы, разница не только в самой загрузке, на VM если образ фрагментирован - тормозит все от простого открытия окна, до административной оснастки. То есть те минимум 30 процентов разницы будут везде, и, допустим, вместо 2-х часов, вы проведете за виртуалкой около 3-х, изрядно помотав себе нервы. Если для вас - это мало, тогда могу только позавидовать неспешности течения вашей жизни. 😀

ну к цифрам не надо придираться, я засекал от нажатия вами кнопки запуска винртульаной машины, что как мне видится особой роли не играет, накиньте недостающие 10 секунд и получите полученный мной результат.

А смысл мне накидывать, если те 10 секунд активность диск минимальная?

а вот с этого места давайте я повторю вопрос - с чего вы вдруг отказались от примера с торрентами и перекинулись на виртуалку?

Я уже ответил выше, могу и повторить

Это же и ответ вам на вопрос с чего я начал дефрагментировать виртуальную машину, просто потому, что делать видео захват с перезагрузкой - не особо хорошая идея, вы потом привяжетесь мол "я ссд подрубил во время обрыва записи"...

ну вот попробуйте залить еще кучу фалов на винт свой, потом увеличить объем выделенный под виртуалку. Посмотрим результаты

Если вы готовы в достаточном объеме оплатить мне стоимость затраченного времени на эксперимент, с удовольствием. 😛

я про это написал вроде, опять пропустили? Я повторю - у меня были случаи, что ускорение в работе системы было в течении пары дней, а потом всё возвращалось на круги своя.

А откуда вы знаете, что у вас было ускорение, или что оно пропало? Может вам показалось просто?

Уж извините не стал писать об этом, так как значения не придал

Ничего ничего, все прошло, как я того и ожидал. Данные о перезагрузке "случайно" "всплыли". 😀

Савва, вы такой придирчивый, что пипец 😊 Особенно радует меня такой момент - что вам предложили обозначить условия эксперимента, вы их описали в 2-х словах, а теперь пеняете мне на то, что я неправильно всё сделал 😊

Ну это лирика конечно, понятно, что я вас не переубежу. Вы меня по данному вопросу тоже врятли переубедите, так что давайте останемся каждый при своем мнении.

З.Ы. спасибо за наводку на прогу ПД, после ее использования мой экспериментальный диск стал меньше трещать 😊

Савва, вы такой придирчивый, что пипец 😊 Особенно радует меня такой момент - что вам предложили обозначить условия эксперимента, вы их описали в 2-х словах, а теперь пеняете мне на то, что я неправильно всё сделал 😊

Ну это лирика конечно, понятно, что я вас не переубежу. Вы меня по данному вопросу тоже врятли переубедите, так что давайте останемся каждый при своем мнении.

Андрей, если бы вы играли честно, вопросов ко мне у вас бы не было. 😛 А так, и эксперимент я описал не правильно, и цепляюсь к вам по чем зря... Может быть наконец, стоит увидеть бревно в своем глазу, а не искать песчинку у других...? Кстати, радует меня такой момент - что вы тактично опустили факт, что в виртуальную машину встроен дефрагментатор для ее образов, что я так же показал на видео. Это достаточно простая логика, производитель подобного ПО не будет тратить деньги на разработку ненужной функции, и встраивать ее для галочки. Значит она нужна. Оставляю сделать выводы самостоятельно.